发布于:2023-02-25 14:49 阅读次数:

可以写段落或画出看起来像人类创造的图片的软件在科技行业掀起了一场淘金热。

微软和谷歌等公司正试图将前沿的人工智能集成到他们的搜索引擎中,因为OpenAI和Stable Diffusion等拥有数十亿美元的竞争对手击败了我们,并向公众发布了他们的软件。

这些应用是由一个大约1万美元的芯片驱动的,这个芯片已经成为人工智能行业最重要的工具之一:Nvidia) A100。

投资人内森贝纳奇(Nathan Benaich)表示,A100已经成为人工智能专业人士的“主力军”,他发表了一份涵盖人工智能行业的时事通讯和报告,其中包括使用A100的超级计算机的部分列表。根据新街研究,英伟达占据了可用于机器学习的图形处理器95%的市场份额。

A100非常适合为ChatGPT、Bing AI或稳定扩散等工具提供动力的机器学习模型。它可以同时执行许多简单的计算,这对训练和使用神经网络模型非常重要。

A100背后的技术最初用于在游戏中渲染复杂的3D图形。它通常被称为图形处理器,但最近,Nvidia的A100被配置为执行机器学习任务,它运行在数据中心,而不是发光的游戏电脑。

从事聊天机器人、图像生成器等软件的大公司或初创企业,需要数百个英伟达芯片。他们要么自己购买,要么从云提供商那里安全地访问计算机。

需要数百个图像处理器(GPU)来训练人工智能模型,例如大型语言模型。芯片需要足够强大,能够快速处理万亿字节的数据,以识别模式。之后像A100这样的GPU也需要“推理”,或者使用模型生成文本,进行预测,或者识别照片中的物体。

这意味着AI需要接触很多A100。这个领域的一些创业者甚至把自己的100号当做进步的标志。

“一年前,我们有32辆A100。”Stability AI首席执行官伊马德穆斯塔克(Imad Mustaq)今年1月在推特上写道,“孩子,梦想大,堆一堆GPU。哦。”Stability AI帮助开发了图像生成器Stable Diffusion,它在去年秋天引起了人们的关注。据悉,该公司估值超过10亿美元。

现在,根据《人工智能状况报告》(AI报告状态)中的一个估计,稳定性AI可以使用5400多个A100 GPUs。这份报告绘制并跟踪了哪些公司和大学拥有最多的A100 GPU——,尽管它不包括云提供商,他们不公开发布他们的数字。

*英伟达正在搭乘人工智能的列车*

英伟达将受益于人工智能炒作周期。在周三的第四季度财报中,虽然整体销售额下降了21%,但投资者在周四推动该股上涨了约14%,主要是因为该公司的人工智能芯片业务——报告称,该季度数据中心——的销售额增长了11%,达到36亿多美元,呈现持续增长。

2023年到目前为止,英伟达的股价已经上涨了65%,超过了标准普尔500指数和其他半导体股票。

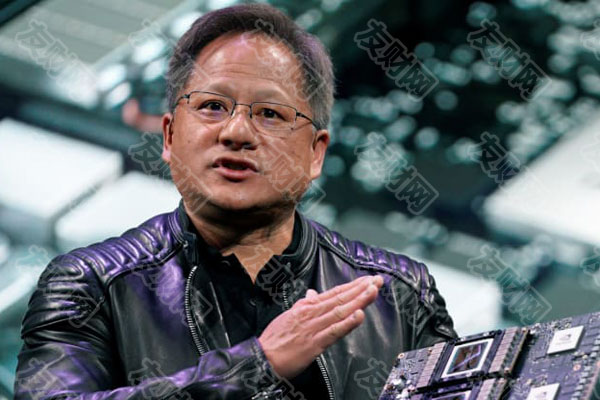

英伟达首席执行官黄仁勋在周三与分析师的电话会议中不断谈论人工智能,这表明人工智能最近的繁荣是该公司战略的核心。

“围绕我们已经建立的人工智能基础设施的活动,以及围绕使用Hopper和Ampere影响大型语言模型推理的活动,在过去60天里刚刚打破了新的记录。”黄仁勋说,“毫无疑问,无论我们如何看待今年,随着我们进入新的一年,过去60或90天的结果已经发生了相当大的变化。”

安培是NVIDIA对A100代芯片的代号。Hopper是新一代产品的代号,包括最近开始出货的H100。

相对于其他类型的软件,如服务网页,处理能力偶尔会在几微秒内突然使用,机器学习任务可能会占用整个计算机的处理能力,有时会持续几个小时或几天。

这意味着,发现自己拥有热门人工智能产品的公司通常需要获得更多GPU来处理高峰期或改进模型。

这些图形处理器并不便宜。除了可以插入现有服务器的卡中的单个A100之外,许多数据中心使用包括八个A100 GPU一起工作的系统。

这个系统是英伟达的DGX A100。虽然它配备了所需的芯片,但建议价格接近20万美元。周三,英伟达表示将直接出售DGX系统的云接入,这可能会降低补丁和研究人员的入门成本。

不难看出A100的成本是如何累积的。

例如,New Street Research的一项估计发现,Bing搜索中基于OpenAI的ChatGPT模型可能需要八个GPU在不到一秒的时间内响应一个问题。

按照这个速度,微软将需要超过2万台8-GPU服务器来将Bing中的模型部署到每个人身上,这意味着微软的这项功能可能需要40亿美元的基础设施支出。

“如果你来自微软,你想扩大规模,像必应一样,可能是40亿美元。如果你想达到谷歌每天服务80亿或90亿次查询的规模,你实际上需要在DGX上花费800亿美元。”新街研究公司的技术分析师安托万切凯说:“我们得出的数字是巨大的。但它们只是反映了一个事实,即每个用户在使用如此庞大的语言模型时,都需要一台巨大的超级计算机。”

根据Stability AI在网上发布的信息,最新版本的图像生成器Stability Diffusion已经在256个A100 GPU上进行了训练,也就是32台机器,每台8个A100,总计20万计算小时。

Stability AI首席执行官穆斯塔克(Mustaq)在推特上表示,根据市场价格,仅训练模型就需要60万美元,并在推特上表示,这个价格与竞争对手相比是极其便宜的。这还不包括“推理”或部署模型的成本。

英伟达首席执行官黄仁勋在接受美国消费者新闻与商业频道采访时表示,就此类模型所需的计算量而言,该公司的产品实际上并不昂贵。

“我们把原来运行CPU价值10亿美元的数据中心压缩成了价值1亿美元的数据中心。”黄仁勋说,“现在,当你把1亿美元放在云端,并与100家公司分享时,这几乎不算什么。”

黄仁勋表示,英伟达的GPU允许初创公司以比使用传统计算机处理器低得多的成本来训练模型。

“现在你可以花1000万到2000万美元来建立一个大型的语言模型,比如GPT。”黄仁勋说,“这真的非常非常实惠。”

*新的竞争*

英伟达并不是唯一一家为人工智能目的制造GPU的公司。AMD和英特尔拥有相互竞争的图形处理器,谷歌和亚马逊等大型云公司正在开发和部署自己专门为人工智能工作负载设计的芯片。

然而,“人工智能硬件仍然与英伟达紧密结合。”根据人工智能计算报告,截至去年12月,超过21000篇开源AI论文表明使用了英伟达芯片。

AI Compute Index的大多数研究人员使用英伟达在2017年推出的芯片V100,但A100在2022年迅速增长,成为第三大使用最多的英伟达芯片,仅次于最初用于1500美元或更低价格游戏的消费级图形芯片。

A100的另一个特点是,它是少数因国防原因而受到出口管制的芯片之一。去年秋天,英伟达在提交给美国证券交易委员会(SEC)的一份文件中表示,美国政府对A100和H100的出口实施了许可要求,禁止向中国、香港和俄罗斯出口。

“美国政府表示,新的许可要求将解决涵盖产品可能在中国和俄罗斯被用于或转让给‘军事最终用途’或‘军事最终用户’的风险。”英伟达在提交材料中表示。英伟达此前表示,针对中国市场调整了部分芯片,以满足美国的出口限制。

A100最激烈的竞争可能是它的继任者。A100最早是在2020年推出的,这在芯片周期中是很长的一段时间。事实上,英伟达周三表示,在截至1月份的季度中,H100芯片的收入超过了A100,尽管H100的单价更高。

英伟达表示,H100是其第一款针对变频进行优化的数据中心GPU。Transformer是一项越来越重要的技术,许多最新、最顶尖的人工智能应用都在使用。英伟达周三表示,希望将人工智能的训练速度提高100万倍以上。这可能意味着人工智能公司最终将不再需要那么多英伟达芯片。